相机传感器:手机拍照背后的“眼睛”

相机传感器:手机拍照背后的“眼睛”

你有没有好奇过,为什么手机拍出来的照片越来越清晰?其实这背后,藏着一个我们平时很少提起的“功臣”——相机传感器。它就像是手机的“眼睛”,负责捕捉光线,再把它们转化成图像。今天我们就来聊聊这个看似不起眼,却无比重要的部件。

想象一下,你正在拍照。阳光洒在你面前的风景上,光线穿过镜头,落在一个小小的芯片上。这个芯片就是相机传感器,它的工作原理其实有点像你小时候玩过的一种游戏:把阳光用纸板剪成不同的形状,投射到地上,形成各种图案。

相机传感器的基本任务就是收集光线,并将其转化为电子信号。这些信号再由手机的处理器处理,最终变成你看到的照片。这个过程听起来简单,其实涉及很多精密的技术。

目前最常见的相机传感器有两大类:CCD和CMOS。CCD传感器像是一位老练的摄影师,拍出来的画面细腻,但速度慢,耗电量大;而CMOS传感器更像是一个年轻、高效的摄影师,速度快、耗电低,但画质略逊一筹。

现在大多数手机都使用CMOS传感器,因为它们更适合移动设备的需求。比如,你用手机连拍好几张照片,CMOS就能快速处理并保存下来,而CCD可能就“喘不过气”来了。

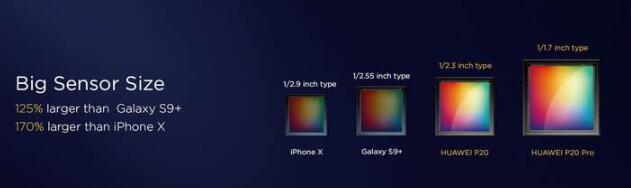

除了种类,相机传感器的大小也很关键。传感器越大,能捕捉的光线越多,拍出来的照片就越清晰。这就像你站在窗边,窗户越大,看到的外面世界就越清楚。

举个例子,一些高端手机用上了“一英寸”大小的传感器,听起来好像不大,但相比普通手机,它能吸收更多光线,尤其是在暗光环境下,拍照效果明显提升。

如果你是个摄影爱好者,可能会听说过“像素”这个词。像素是图像的基本单位,像素越高,照片越清晰。但这里有个误区:相机传感器的像素高,不等于照片就一定好。关键还是看传感器的大小和质量。

比如,一个4800万像素的小传感器,可能还不如一个1200万像素的大传感器拍出来的照片好。这就像是你用一个大碗装水,肯定比小碗装得多,哪怕碗里的水少。

说到应用,相机传感器几乎无处不在。除了手机,它还出现在安防摄像头、无人机、自动驾驶汽车,甚至医疗设备中。在自动驾驶里,传感器负责识别前方的车辆、行人和交通信号,是保障安全的关键。

而在无人机上,相机传感器不仅用来拍照,还能帮助无人机“看”清地形,避免撞上障碍物。这有点像你骑自行车时,眼睛不断扫视前方,调整方向。

说到未来,相机传感器的技术也在不断进步。比如,现在的手机已经开始尝试多传感器组合,用多个摄像头来提升拍照效果,像是用多个眼睛看世界,看得更全面。

此外,随着人工智能的发展,传感器和算法结合得越来越紧密。比如,一些手机能自动识别场景,调整拍照参数,让照片更接近人眼的观感。

如果你对技术感兴趣,也可以尝试去了解传感器背后的数据处理流程。简单说,传感器捕捉到光信号后,这些信号需要被转换为数字信息,再通过算法优化,最终生成我们看到的照片。

不过,技术的进步并不意味着每个人都要成为专家。对于普通用户来说,了解一点基础,比如传感器的大小、类型和像素,就能在选购手机时做出更明智的选择。

最后,或许你会想,相机传感器是不是越先进越好?其实不然,适合自己的才是最好的。比如,如果你主要用来日常拍照,一款中等性能的传感器就完全够用了。但如果你是摄影爱好者,那就值得为更好的传感器多花点心思。

下次你拍照时,不妨多想想,那些光是怎么被“看见”的,背后那颗小小的芯片,其实藏着很多科技的奥秘。

查看全文

小道芯信息

小道芯信息

评论0条评论